손실함수

딥러닝의 회귀에서는 주로 MSE, 분류에서는 주로 Cross Entropy(binary, categorical)를 사용한다.

위의 그림 마지막 output 단계에서 분류나 회귀를 이용한다.

MSE

MSE는 오류 값의 제곱을 구해서 더한 뒤 이를 데이터의 개수로 나누는 방식이다. 제곱을 하는 이유는 미분의 계산을 편리하기 위해 구한다.

Cross Entropy Loss(Softmax)

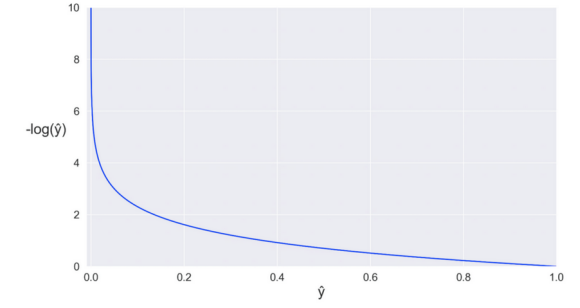

밑의 그림은 softmax일 경우의 손실함수이다.

실제값을 1 아닌값을 전부 0으로 하여 인코딩 해준것이다. 아래의 그래프를 보면 예측한 값이 1에 가까울수록 loss값은 0에 수렴하는 것을 볼수있다. 반대로 값이 작아질 경우 loss값이 기하급수적으로 증가한다.

Cross Entropy Loss(Sigmoid)

위의 식은 Sigmoid의 손실함수이다.

case 1

case 0

실제값이 1일때 위와같은 식만 남고 실제값이 0일때 아래의 식만 남는다.

'컴퓨터비전' 카테고리의 다른 글

| [딥러닝] 딥러닝의 모델 (0) | 2022.03.10 |

|---|---|

| [딥러닝] 딥러닝의 Optimizer (0) | 2022.03.08 |

| [딥러닝] 활성화 함수( Activation Function) (0) | 2022.03.08 |

| [딥러닝] 다층 퍼셉트론(Multi Layer Perceptron)의 개요 (0) | 2022.03.06 |

| [딥러닝] 단층 퍼셉트론(Single Layer Perceptron)의 개요 (0) | 2022.03.05 |

댓글