가중치 초기화의 중요성

왼쪽 그림은 평균이 0 표준편차가 1 인 경우이고, 오른쪽 그림은 평균이 0 표준편차가 0.01인 경우이고. 각각 시그모이드 함수를 적용하였다. 왼쪽 같은 경우에는 값이 0과 1에 수렴되고, 오른쪽은 0.5에 수렴된다. 뉴런 네트워크에서 backpropagation으로 가중치를 업데이트할 경우 활성화 함수의 출력 값이 0이나 1에 가까운 값이면 업데이트가 이루어지지 않고, 뉴런의 활성화 함수의 출력 값이 비슷하면 여러 개로 구성하는 의미가 사라지게 된다.

Xavier Glorot Initialization

이전 노드와 다음 노드의 개수에 의존하는 방법이다. Uniform 분포, Normal분포 이 두가지 방법이 사용된다.

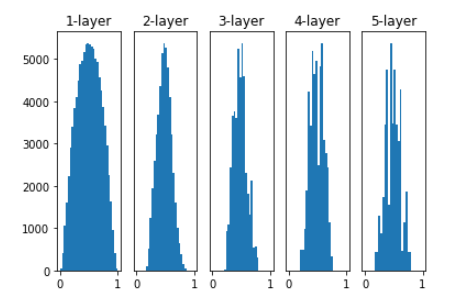

이전에 Random으로 주어졌을 경우보다 더 고르게 퍼져있음을 볼수있다.

He Initialization

He Initialization은 ReLu함수를 활성화 함수로 할 때 추천되는 방법이다. 마찬가지로 Uniform 분포, Normal분포 이 두 가지 방법이 사용되지만, fan in 이전 노드만 사용한다는 차이점이 있다.

'컴퓨터비전' 카테고리의 다른 글

| [딥러닝] R-CNN 논문 리뷰 (0) | 2022.03.23 |

|---|---|

| [딥러닝] Object Detection이란? (0) | 2022.03.22 |

| [딥러닝] 딥러닝의 모델 (0) | 2022.03.10 |

| [딥러닝] 딥러닝의 Optimizer (0) | 2022.03.08 |

| [딥러닝] 딥러닝의 손실 함수 (0) | 2022.03.08 |

댓글