결합 엔트로피, 조건부 엔트로피 링크

[통계] 결합엔트로피, 조건부엔트로피

엔트로피 설명 링크 [통계] 정보량과 엔트로피 정보량이란? 확률이 낮을수록, 어떤 정보일지 불확실하게 되고, 이때 "정보가 많다", "엔트로피가 높다"라고 표현합니다. 예시를 들어봅시다. 저희

lcyking.tistory.com

Cross Entropy와 Kullback-Leibler Divergence(KLD) 링크

[통계] Cross Entropy, Kullback-Leibler Divergence

정보량과 엔트로피 링크 [통계] 정보량과 엔트로피 정보량이란? 확률이 낮을수록, 어떤 정보일지 불확실하게 되고, 이때 "정보가 많다", "엔트로피가 높다"라고 표현합니다. 예시를 들어봅시다.

lcyking.tistory.com

주변 확률 질량 함수 링크

[통계] 주변확률질량함수, 주변확률밀도함수

주변확률분포 주변확률분포는 결합확률분포를 전제로 합니다. 아래의 글을 보고 오시는 것을 추천합니다! https://lcyking.tistory.com/118 결합확률분포에서 확률변수 X, Y의 결합확률분포 \( P_{x, y}(x, y)

lcyking.tistory.com

참고

https://mons1220.tistory.com/128

https://bskyvision.com/entry/%EC%A0%95%EB%B3%B4%EC%9D%B4%EB%A1%A0-%EC%83%81%ED%98%B8%EC%A0%95%EB%B3%B4%EB%9F%89mutual-information%EC%9D%B4%EB%9E%80https://en.wikipedia.org/wiki/Mutual_information

결합 엔트로피의 독립

위의 식이 기본 X, Y의 엔트로피를 구하는 식입니다. 확률변수 Y값이 관측됐을 때, 확률변수 X가 발생할 확률에 대한 정보량의 기댓값입니다. 만약 독립적인 관계라면 어떻게 될까요? \(p(x_i, y_i) = p(x_i) p(y_j) \)가 될 겁니다. 그럼 아래와 같이 증명이 가능합니다

\( H(X, Y) = H(X) + H(Y) \) 가 나옵니다. 이 증명을 왜 했냐 하면 아래에 상호 정보량에서 다시 설명합니다.

상호정보량

상호 정보량이 무엇이냐 하면, 하나의 확률변수가 다른 하나의 확률변수에 대해 제공하는 정보의 양이고, 상호 의존성을 측정하는 척도입니다. X의 무작위 변수 \( x_random \) 과 Y의 무작위변수 \( y_random \)이 있다고 가정했을 때, 여기서 얻은 "정보의 양"을 말합니다. 이 정보의 양의 평균이 상호 정보량입니다. 정보의 양이니까 엔트로피 개념과 아주 큰 연관이 있죠.

자 그럼 이제 어떻게 생긴 공식인지 살펴보겠습니다.

\( I(X; Y) = D_{KL}(P_{(X, Y)} || P_X \otimes P_Y) \)

\( D_{KL} \)은 KLD이고, \( \otimes \)는 확률 분포의 곱입니다. KLD의 수식을 적용하여, 풀어서 설명하면 아래와 같은 수식이 나옵니다.

\( D_{KL}(p||q) = \sum_{i=1}^K p(y_i) log_2 (\frac {p(y_i)} {q(y_i)}) \)

\( I(X;Y) = \sum_{y \in Y} \sum_{x \in X} P_{(X, Y)}(x, y) log (\frac {P_{(X, Y)} (x, y)} {P_X(x) P_Y(y)}) \)

여기서 \( p(x, y) \)는 결합 확률 함수, \( p(x), p(y) \)는 주변 확률 함수입니다.

X, Y가 독립이면 \( P(x, y) = p(x) p(y) \)

저번 Kullback-Leibler Divergence포스팅에서 Cross Entropy와 KLD사이의 수식을 도출하는 것을 봤습니다.

\( Cross Entropy H(p, q) = H(p) + KLD(p||q) \)라는 것을 확인했죠? 여기서 KLD는 정보량 차이이라고 했고요. 그래서 p의 분포와 q의 분포가 같아질수록 \( log 1 = 0 \)에 수렴하는 것이죠.

상호 정보량은 상호 의존성을 측정하는 척도라고 말씀드렸죠? X를 안다고 하면, Y가 어떤 정보를 주는지 측정하고, 그 반대도 성립합니다. 그럼 만약 X, Y가 독립일 때는 어떻게 될까요? X가 Y의 정보를 알 수 없고, Y도 X의 정보를 알 수 없습니다. 교차하는 부분이 없으니까요. 그럼 상호 정보량 = 0 이 되고, \( I(X; Y) = 0 \)이 됩니다.

\( I(X; Y) \)를 0으로 만들려면, KLD와 똑같이 \( log 1 = 0 \)이라는 식으로 만들어주면 돼서, \( P(x, y) = p(x) p(y) \)라는 식이 도출돼는 것이죠.

\( I(X;Y) = H(X) + H(Y) - H(X, Y) \)

H는 정보량의 평균(엔트로피)죠? X, Y 각각의 정보량을 더한 다음에 두 가지를 합한 정보량을 빼면 상호 정보량이 나옵니다.

\( H(X, Y) \)는 두 가지의 결합된 정보량을 가지고 있습니다. 그럼 X, Y의 모든 정보를 가지고 있겠죠? 아래 그림으로 쉽게 설명해드리죠.

이해가 되시나요? 두 확률변수 X, Y를 따로 보았을 때보다 같이 보았을 때 얼마나 더 불확실성이 감소하였는가를 정량화한 것이 상호 정보량입니다. 말이 참 어렵죠...?? 자 쉽게 설명해보죠. 예전 정보량과 엔트로피의 포스팅에서 불확실성이 높다는 것은 즉, 예측하기 힘듬을 의미하죠. 그럼 불확실성을 감소하는 방향은 무엇이죠? 예측하기 쉬운 방향이겠죠?

예측하기 쉬운 것이란 위에서 무엇일까요? \( H(X), H(Y) \) 서로 알고 있는(교집합으로 생각) 데이터 \( I(X; Y) \)라는 것이죠.

이렇게 하는 게 \( H(X), H(Y) \)의 정보들을 따로 들고 다니는 것보다 정보를 압축할 수 있다는 의미입니다.

조건부 엔트로피로 수식을 유도해보겠습니다. 기본 수식은 아래와 같습니다.

조건부 확률처럼, Y의 값을 알 때, X가 발생할 확률에 정보량의 기댓값입니다. 자세한 내용은 위 링크를 타고 확인해보시길 바랍니다. 그럼 수식을 유도해보면,

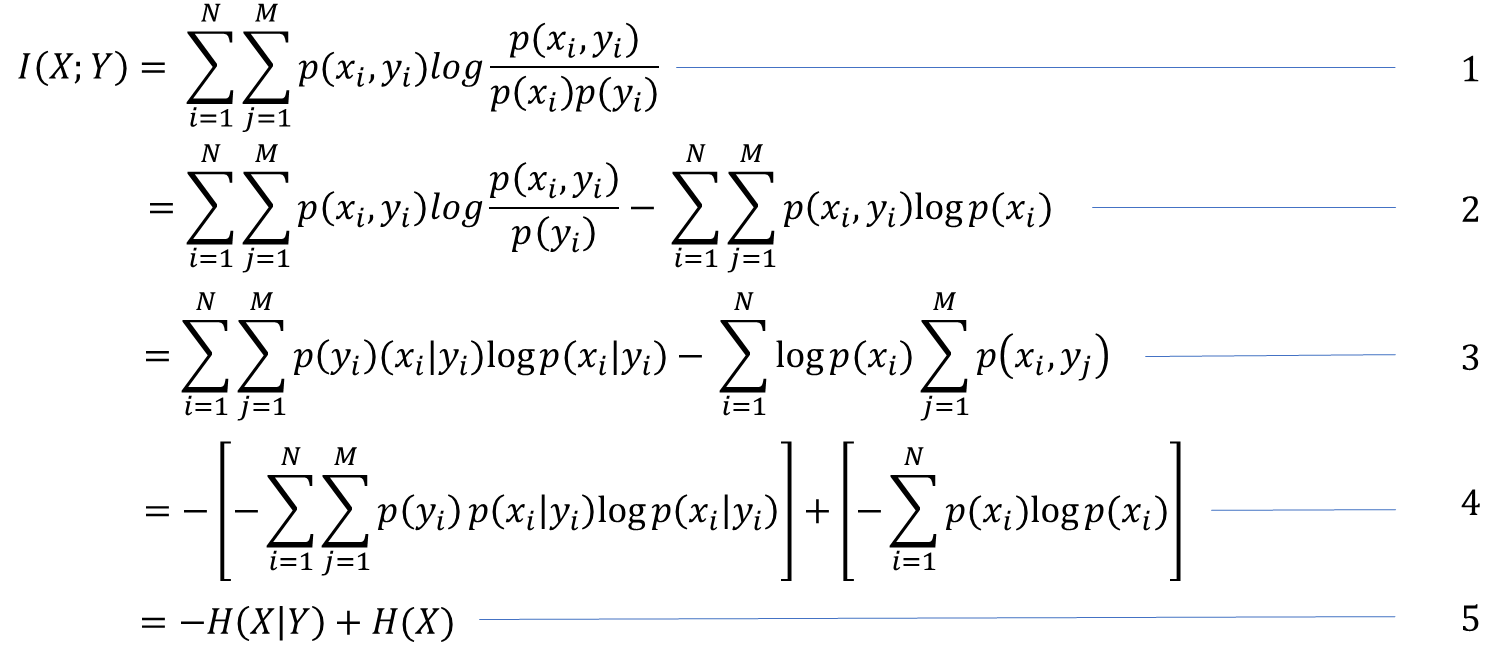

- 기본 \(I(X; Y) \) 공식이죠?

- \( log \)의 성질에 의해 x가 빠져나왔습니다.

- 앞의 식에 \( p(x_i, y_i) \)를 조건부 확률로 풀어쓰고 log안의 \( \frac {p(x_i, y_i)} {p(y_i)} \)도 풀어썼습니다. 뒤는 시그마의 성질로 분리를 시켰습니다.

- 앞의 식에 -(-)를 붙여주었고, 뒤의 \( \sum_{i=1}^N \sum_{j=1}^M p(x_i, y_j \)는 주변 확률분포의 성질에 의해 \( \sum_{i=1}^N p(x_i) \)로 변경되었습니다. 이제 익숙한 수식이죠?

- 최종식 \( - H(X|Y) + H(X) \)가 나왔습니다. (2번에서 x가 아닌 y가 빠져나온다는 식이 \( - H(Y|X) + H(Y) \)가 나옵니다.

상호 정보량의 식들을 종합해볼까요?

- 첫 번째 줄은 X, Y가 독립일 경우 \(H(X, Y) \)는 \(H(X) + H(Y) \)이므로 0이 나와서, 독립일 경우에 불확실성이 얼마나 감소하였는가

- 두 번째 줄은 \( H(X) \)는 고정 상수값이고, \( Y \)를 아는 것으로, \( X \)의 불확실성이 얼마나 감소하였는가

- 세 번째 줄은 \( H(Y) \)는 고정 상수값이고, \( X \)를 아는 것으로, \( Y \)의 불확실성이 얼마나 감소하였는가

를 의미합니다.

'통계' 카테고리의 다른 글

| [딥러닝] 논문에서 많이 사용되는 수학 기호, 약어 모음집 (0) | 2024.01.12 |

|---|---|

| [통계] Cross Entropy, Kullback-Leibler Divergence (0) | 2022.11.15 |

| [통계] 결합엔트로피, 조건부엔트로피 (0) | 2022.11.15 |

| [통계] 조건부확률질량함수, 조건부확률밀도함수 (0) | 2022.11.15 |

| [통계] 주변확률질량함수, 주변확률밀도함수 (0) | 2022.11.15 |

댓글